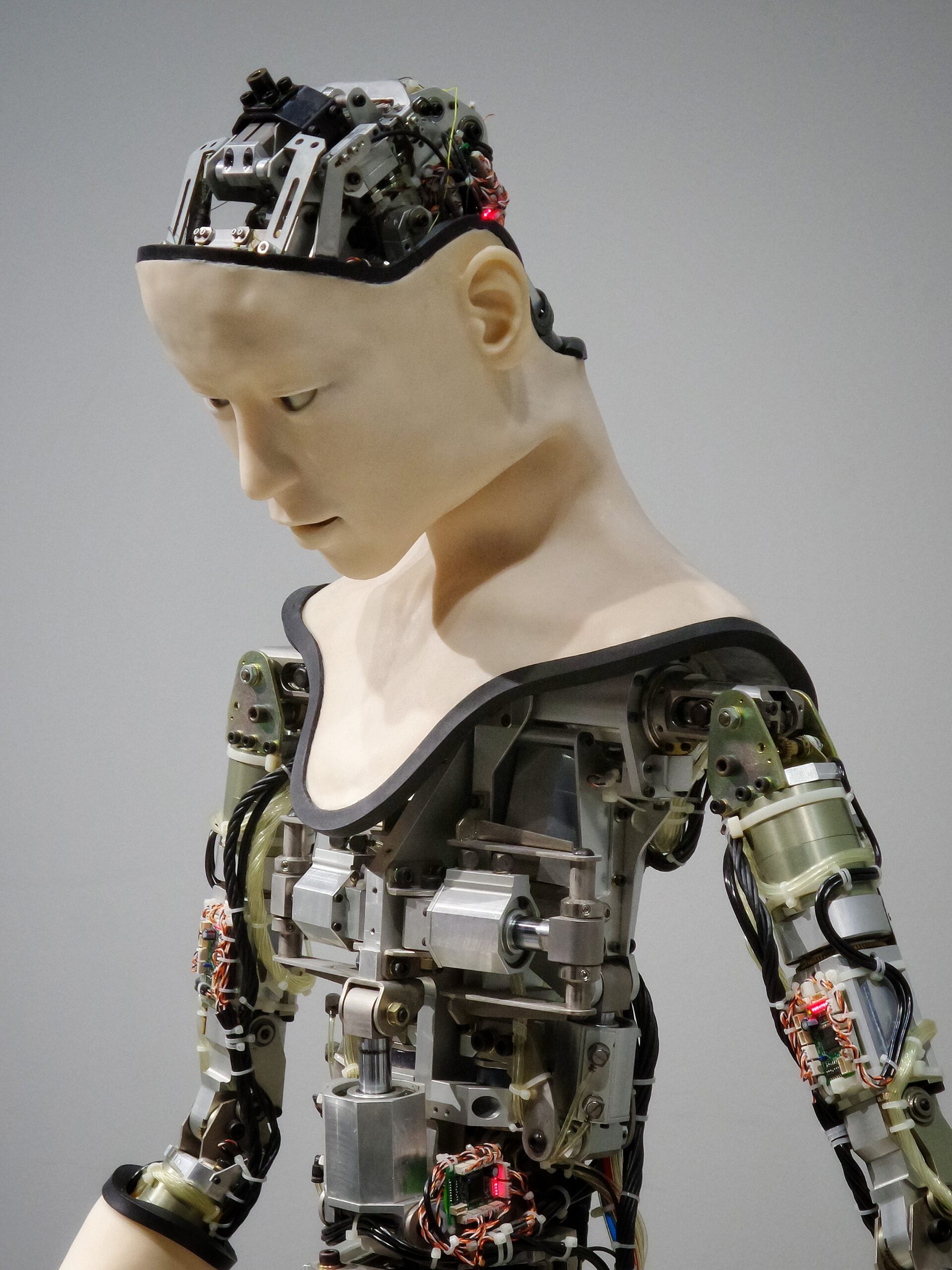

En tiempos donde la incorporación de tecnologías basadas en inteligencia artificial ha salido de la categoría de ciencia ficción para convertirse en una realidad en una gran cantidad de industrias, es frecuente percibir un cierto temor hacia la incorporación de “máquinas” en el mercado laboral, leer o escuchar predicciones del tipo “La mayoría de la fuerza laboral será reemplazada por máquinas en el mediano plazo”.

Si bien no cabe duda de que este temor en muchos casos puede estar bien fundado, es importante tener en cuenta en qué medida las máquinas nos necesitan y que de lo contrario su incorporación puede ser incluso un despropósito.

¿De qué depende que una herramienta de inteligencia artificial pueda ser exitosa? Para simplificar el análisis, pensemos en una herramienta para identificar riesgos de crédito.

La respuesta en simple es: Depende fundamentalmente de los datos que tengamos. Esto último a su vez, depende fundamentalmente de la forma de recolección de estos. Finalmente, depende de criterios, opiniones y decisiones tomadas por personas.

Los modelos de machine learning, subyacentes en la herramienta de inteligencia artificial, aprenden de los datos históricos disponibles, identificando las relaciones entre una variable de interés (fraude o no fraude) y características (comuna, antigüedad laboral, nivel educacional, edad, industria, sexo, u otras) que sean más exitosas para predecir un fraude.

Aquí los conceptos “datos históricos” y “características” pueden generar al menos dos fuentes de problemas:

- Sesgos de selección: En el caso de una empresa que haga clasificación de riesgo de créditos, tenemos historia de fraudes de personas que han tenido crédito y que, por lo tanto, fueron previamente aprobadas para recibir el crédito. ¿Cuál es el problema? Que la muestra puede estar dejando afuera a personas con otras características y no sabemos si son riesgosas o no.

- Sesgos de variables omitidas. Las personas con historia de crédito llenaron formularios en los que se les preguntó una serie de características. Probablemente puede haber muchos factores que incidan en el riesgo crediticio y que pueden no haber sido encuestados en el formulario.

El problema de sesgo de selección al final va a invalidar las métricas de precisión de nuestro modelo al aplicarlo sobre cualquier solicitud nueva de crédito, ya que la muestra de entrenamiento puede no ser representativa. En simple, el modelo aprendió a predecir correctamente la probabilidad de fraude sobre personas previamente aprobadas al otorgamiento de crédito, por lo que probablemente se va a equivocar cuando prediga sobre personas que no hubiesen sido aprobadas según los criterios de los evaluadores de crédito.

En este caso las máquinas necesitan a los hombres porque la solución ideal a este problema es nutrir los datos con que se entrena el modelo. Necesitamos construir una muestra que sea lo más representativa de la realidad. Sin embargo, a veces esto puede ser muy caro o generar otros problemas (ej. muestras muy desbalanceadas), que pueden afectar el nivel de precisión de los modelos.

El problema de omisión de variables también releva la necesidad de los hombres que tienen las máquinas. Este problema se va a traducir principalmente en error de predicción. El modelo no va a poder aprender a clasificar bien porque le falta información.

Estos dos problemas pueden solucionarse -o al menos abordarse- si es que los modelos son correctamente administrados e implementados por personas. Es por esto que otro de los dichos que se escucha cada vez más seguido, es que los data scientists serán cada vez más requeridos en todo tipo de empresas y áreas. Si queremos incorporar tecnología y hacerlo bien, las máquinas nos necesitan.